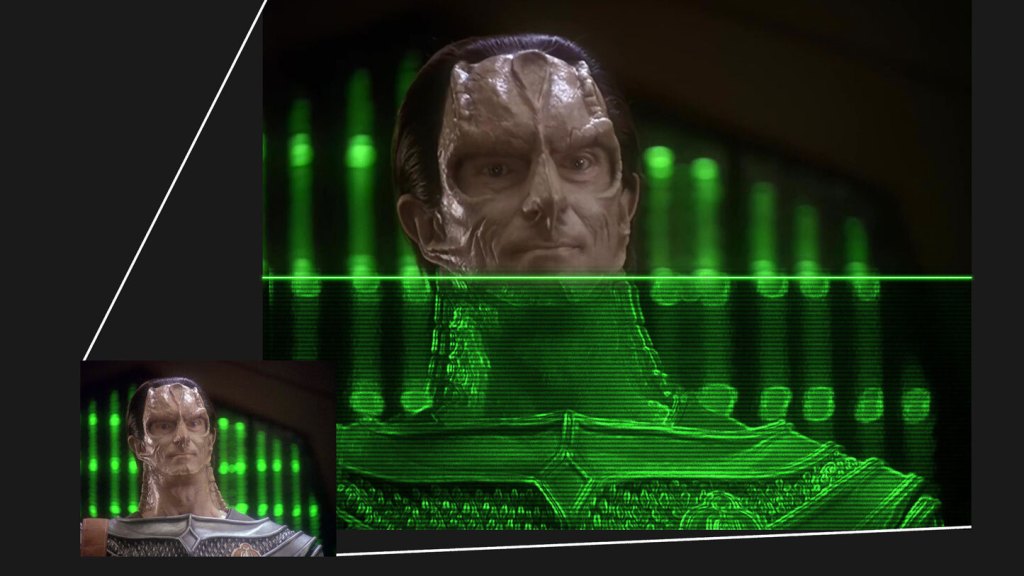

Por anos, os dedicados fãs de Star Trek têm usado inteligência artificial na tentativa de fazer uma versão da aclamada série Deep Space 9 que pareça decente em TVs modernas. Parece um pouco ridículo, mas fiquei surpreso ao descobrir que na verdade é muito bom - certamente bom o suficiente para as empresas de mídia prestarem atenção (em vez de apenas me enviarem notificações de direitos autorais).

Fui inspirado no início deste ano a assistir o programa, um favorito dos fãs que ocasionalmente via na TV quando era exibido, mas nunca realmente pensei duas vezes sobre. Após ver a remasterização reveladora de Star Trek: The Next Generation, senti que deveria revisitar seu irmão menos viajante pela galáxia e mais focado no ensemble. Talvez, pensei, estivesse no meio de um extenso processo de remasterização também. Não!

Infelizmente, descobri que, embora a remasterização de TNG tenha sido um enorme triunfo técnico, o momento coincidiu com o surgimento dos serviços de streaming, o que significa que o caro conjunto de Blu-ray teve vendas baixas. O processo custou mais de US$ 10 milhões e, se não compensou para a série mais popular e confiável da franquia, não há como os poderes que comandam fazerem isso de novo para DS9, muito amada, mas muito menos rentável.

O que isso significa é que se você quiser assistir DS9 (ou Voyager, por falar nisso), terá que assisti-lo mais ou menos na qualidade em que foi transmitido nos anos 90. Assim como TNG, foi filmado em filme, mas convertido para fita de vídeo com aproximadamente 480p de resolução. E, embora os DVDs tenham proporcionado uma melhor qualidade de imagem do que as transmissões (devido a coisas como pull-down e profundidade de cor), eles ainda, em última análise, foram limitados pelo formato em que o programa foi finalizado.

Para ampliar com coragem...

Por anos, fãs de programas e filmes deixados para trás pelo trem do HD trabalharam secretamente para encontrar e distribuir versões melhores do que as disponibilizadas oficialmente. O exemplo mais famoso é a trilogia original de Star Wars, que foi irreversivelmente comprometida por George Lucas durante o processo oficial de remasterização, levando os fãs a encontrar fontes alternativas para certas cenas: laserdiscs, edições limitadas, mídias promocionais, bobinas de arquivo esquecidas e assim por diante. Essas edições totalmente não oficiais são um trabalho constante em progresso e, nos últimos anos, começaram a implementar novas ferramentas baseadas em IA também.

Essas ferramentas são principalmente sobre ampliação inteligente e remoção de ruído, sendo este último mais preocupante no mundo de Star Wars, onde algumas das filmagens originais são incrivelmente granuladas ou degradadas. Mas você pode pensar que ampliar, aumentar o tamanho de uma imagem, é um processo relativamente simples - por que envolver a IA?

Certamente existem maneiras simples de ampliar, ou converter a resolução de um vídeo para uma resolução mais alta. Isso é feito automaticamente quando você tem um sinal de 720p indo para uma TV 4K, por exemplo. A imagem de resolução 1280x720 não aparece toda pequena no centro do display de 3840x2160 - ela é esticada por um fator de 3 em cada direção para se adequar à tela; mas embora a imagem pareça maior, ela ainda é 720p em resolução e detalhes.

Um algoritmo simples e rápido como o filtro bilinear torna uma imagem menor aceitável em uma tela grande, mesmo quando não é um estiramento exato de 2x ou 3x, e existem alguns métodos de escalonamento que funcionam melhor com alguns tipos de mídia (por exemplo, animação ou arte em pixel). Mas, no geral, você pode concluir justamente que não há muito a ganhar com um processo mais intensivo.

E isso é verdade até certo ponto, até você começar a descer na toca do coelho quase inesgotável de criar um processo de ampliação melhorado que realmente adiciona detalhes. Mas como você pode “adicionar” detalhes que a imagem não contém? Bem, ela contém - ou melhor, implica.

Aqui está um exemplo muito simples. Imagine uma TV antiga mostrando uma imagem de um círculo verde em um fundo que desvanece do azul para o vermelho (usei este filtro CRT para uma simulação básica).

Você pode ver que é um círculo, é claro, mas se olhar de perto, é na verdade bastante borrado onde o círculo e o fundo se encontram, certo, e marcado na graduação de cores? É limitado pela resolução e pelo codec de vídeo e método de transmissão, sem mencionar o layout de subpixels e os fósforos de uma TV antiga.

Mas se eu pedisse para você recriar essa imagem em alta resolução e cor, você poderia fazer isso com melhor qualidade do que jamais viu, mais nítida e com cores mais suaves. Como? Porque há mais informações implícitas na imagem do que simplesmente o que você vê. Se você tem uma ideia razoável do que estava lá antes que esses detalhes fossem perdidos quando foi codificado, você pode colocá-los de volta, assim:

Há muito mais detalhes na imagem que simplesmente não são visíveis - então, na verdade, não estamos adicionando, mas sim recuperando. Neste exemplo, fiz a mudança de forma extrema para chamar a atenção (é bastante chocante, na verdade), mas em imagens fotográficas costuma ser muito menos marcante.

Ampliação inteligente

O exemplo acima é um exemplo muito simples de recuperação de detalhes, e na verdade algo que vem sendo feito sistematicamente há anos em esforços de restauração em diversos campos, digitais e analógicos. Mas enquanto você pode ver que é possível criar uma imagem com mais detalhes aparentes do que a original, você também percebe que isso só é possível com um certo nível de entendimento ou inteligência sobre essa imagem. Uma simples fórmula matemática não consegue fazer isso. Felizmente, estamos muito além dos dias em que uma simples fórmula matemática era nosso único meio de melhorar a qualidade da imagem.

De ferramentas de código aberto a ferramentas de marcas como Adobe e Nvidia, o software de ampliação se tornou muito mais comum à medida que as placas de vídeo capazes de fazer os cálculos complexos necessários para fazê-lo se proliferaram. A necessidade de atualizar elegantemente um trecho ou screenshot de baixa resolução para alta é comum nos dias de hoje em dezenas de indústrias e contextos.

Suites de efeitos de vídeo agora incorporam análise de imagem complexa e algoritmos sensíveis ao contexto, para que, por exemplo, a pele ou o cabelo sejam tratados de forma diferente da superfície da água ou do casco de uma nave espacial. Cada parâmetro e algoritmo pode ser ajustado e ajustado individualmente, dependendo da necessidade do usuário ou das imagens sendo ampliadas. Entre as opções mais utilizadas está o Topaz, uma suíte de ferramentas de processamento de vídeo que empregam técnicas de aprendizado de máquina.

O problema dessas ferramentas é duplo. Primeiro, a inteligência vai apenas até certo ponto: configurações que podem ser perfeitas para uma cena no espaço são totalmente inadequadas para uma cena interior, ou uma floresta tropical ou luta de boxe. De fato, até múltiplos tiros dentro de uma única cena podem exigir abordagens diferentes: diferentes ângulos, características, tipos de cabelo, iluminação. Encontrar e travar essas configurações no ponto ideal é muito trabalho.

Segundo, esses algoritmos não são baratos ou (especialmente quando se trata de ferramentas de código aberto) fáceis. Você não paga apenas por uma licença do Topaz - você precisa executá-lo em algo, e cada imagem que você passa por ele usa uma quantidade não desprezível de energia computacional. Calcular os vários parâmetros para um único quadro pode demorar alguns segundos e, quando se considera que há 30 quadros por segundo por 45 minutos por episódio, de repente você está usando seu GPU de $1.000 no limite por horas a fio - talvez apenas para jogar fora os resultados quando encontrar uma combinação melhor de configurações um pouco mais tarde. Ou talvez você pague pelo cálculo na nuvem, e agora seu hobby tem mais uma mensalidade.

Felizmente, há pessoas como Joel Hruska, para quem esse processo meticuloso e custoso é um projeto de paixão.

“Tentei assistir ao programa na Netflix”, ele me disse em uma entrevista. “Foi abominável.”

Assim como eu e muitos (mas não tantos) outros, ele esperava ansiosamente por uma remasterização oficial desse show, da mesma forma que os fãs de Star Wars esperavam uma remasterização abrangente do corte teatral da trilogia original de Star Wars. Nenhuma das comunidades obteve o que queria.

“Estou esperando há 10 anos para a Paramount fazer isso, e eles não fizeram”, ele disse. Então, ele se juntou aos outros fãs cada vez mais bem equipados que estavam tomando o assunto em suas próprias mãos.

Tempo, terabytes e gosto

Hruska documentou seu trabalho em uma série de posts no ExtremeTech, e sempre faz questão de explicar que está fazendo isso para sua própria satisfação e não para ganhar dinheiro ou lançar publicamente. Na verdade, é difícil imaginar até mesmo um artista profissional de efeitos visuais indo aos comprimentos que Hruska foi para explorar as capacidades de ampliação por IA e aplicá-las a esse programa em particular.

“Isso não é uma promoção, mas não vou mentir”, ele começou. “Já trabalhei nisso às vezes por 40-60 horas por semana. Codifiquei o episódio 'Sacrifice of Angels' mais de 9.000 vezes. Fiz 120 encodes no Handbrake - testei todos os parâmetros ajustáveis para ver como seriam os resultados. Tive que dedicar 3,5 terabytes a episódios individuais, apenas para os arquivos intermediários. Eu brute-forcei isso em um grau enorme… e falhei tantas vezes.”

Ele me mostrou um episódio que havia codificado e que realmente parecia ter sido remasterizado corretamente por uma equipe de especialistas - não a ponto de você pensar que foi filmado em 4K e HDR, mas apenas para que você não fique constantemente pensando “meu Deus, a TV realmente parecia assim?” o tempo todo.

“Posso criar um episódio de DS9 que parece ter sido filmado em 720p inicial. Se você assistir de 7 a 8 pés de distância, parece bastante bom. Mas foi um longo e sinuoso caminho para a melhoria”, ele admitiu. O episódio que ele compartilhou era “uma compilação de 30 ampliações diferentes de 4 diferentes versões do vídeo.”

Parece exagerado, sim. Mas também é uma demonstração interessante das capacidades e limitações da ampliação por IA. A inteligência que ela possui é muito limitada em escala, mais preocupada com pixels e contornos e gradientes do que com qualidades muito mais subjetivas de o que parece “bom” ou “natural”. E da mesma forma que ajustar uma foto de uma maneira pode destacar os olhos de alguém, mas estourar a pele, e de outra maneira vice-versa, uma abordagem iterativa e em camadas é necessária.

O processo, então, é muito menos automatizado do que se poderia esperar - é uma questão de gosto, familiaridade com a tecnologia e serendipidade. Em outras palavras, é uma arte.

“Quanto mais eu fiz, mais descobri que você pode extrair detalhes de lugares inesperados”, ele disse. “Você pega essas diferentes codificações e as mistura, você extrai detalhes de maneiras diferentes. Uma é para nitidez e clareza, a próxima é para curar algum dano, mas quando você as coloca uma sobre a outra, o que você obtém é uma versão distinta do vídeo original que enfatiza certos aspectos e regride qualquer dano que você fez.”

“Não se deve passar um vídeo pelo Topaz 17 vezes; é desaprovado. Mas funciona! Muito do velho livro de regras não se aplica”, ele disse. “Se você tentar seguir o caminho mais simples, você terá um vídeo reproduzível, mas ele terá erros de movimento [ou seja, artefatos de vídeo]. Isso te incomoda muito? Algumas pessoas não ligam! Mas estou fazendo isso para pessoas como eu.”

Como tantos projetos de paixão, o público é limitado. “Gostaria de poder lançar meu trabalho, realmente gostaria,” Hruska admitiu. “Mas isso colocaria um alvo nas minhas costas.” Por enquanto, é para ele e outros fãs de Trek desfrutarem, se não em segredo, pelo menos com plausível negação.

Em tempo real com Odo

Qualquer um pode ver que as ferramentas e serviços alimentados por IA estão caminhando para a acessibilidade. O tipo de análise de imagem que o Google e a Apple costumavam fazer na nuvem agora pode ser feito no seu telefone. A síntese de voz também pode ser feita localmente, e em breve podemos ter uma IA conversacional semelhante ao ChatGPT que não precisa se conectar à internet. Quão divertido será isso!

Isso é possibilitado por diversos fatores, um dos quais são chips dedicados mais eficientes. As GPUs fizeram o trabalho bem, mas foram originalmente projetadas para outra coisa. Agora, pequenos chips estão sendo construídos do zero para realizar o tipo de matemática no coração de muitos modelos de aprendizado de máquina, e estão cada vez mais presentes em telefones, TVs, laptops, você escolhe.

A ampliação inteligente em tempo real não é nem simples nem fácil de ser feita corretamente, mas é claro para quase todos na indústria que pelo menos faz parte do futuro do conteúdo digital.

Imagine as economias de largura de banda se a Netflix pudesse enviar um sinal de 720p que parecesse 95% do bom de um sinal 4K quando sua TV ampliasse - executando os algoritmos especiais da Netflix. (Na verdade, a Netflix já faz algo do tipo, embora essa seja uma história para outra hora.)

Imagine se o último jogo sempre rodasse a 144 quadros por segundo em 4K, pois na verdade ele é renderizado em uma resolução mais baixa e ampliada intelligentemente a cada 7 microssegundos. (Isso é o que a Nvidia vislumbra com o DLSS e outros processos que suas placas mais recentes permitem.)

Hoje, o poder de fazer isso ainda está um pouco além do laptop ou tablet médio e mesmo as GPUs poderosas fazendo ampliação em tempo real podem produzir artefatos e erros devido a seus algoritmos mais genéricos.

Derrube-me com direitos autorais, e… (você conhece o resto)

A abordagem de criar sua própria versão ampliada de DS9 (ou, tanto faz, Babylon 5 ou outro show ou filme que nunca teve a dignidade de uma remasterização em alta definição) é certamente a legal, ou a mais próxima disso. Mas a simples verdade é que sempre há alguém com mais tempo e expertise, que fará o trabalho melhor