O CEO da Nvidia, Jensen Huang, diz que o desempenho dos chips de IA de sua empresa está avançando mais rapidamente do que as taxas históricas estabelecidas pela Lei de Moore, o princípio que impulsionou o progresso da computação há décadas.

“Nossos sistemas estão progredindo muito mais rápido do que a Lei de Moore”, disse Huang em uma entrevista ao TechCrunch na terça-feira, a manhã após ele ter feito uma apresentação para uma plateia de 10.000 pessoas na CES em Las Vegas.

Cunhada pelo co-fundador da Intel, Gordon Moore, em 1965, a Lei de Moore previa que o número de transistores nos chips de computador dobraria aproximadamente a cada ano, essencialmente dobrando a performance desses chips. Essa previsão em sua maioria se concretizou, e criou avanços rápidos em capacidade e custos em queda por décadas.

Nos últimos anos, a Lei de Moore desacelerou. No entanto, Huang afirma que os chips de IA da Nvidia estão avançando em um ritmo acelerado próprio; a empresa diz que seu mais recente superchip de centro de dados é mais de 30 vezes mais rápido para executar cargas de trabalho de inferência de IA do que sua geração anterior.

“Podemos construir a arquitetura, o chip, o sistema, as bibliotecas e os algoritmos tudo ao mesmo tempo”, disse Huang. “Se fizer isso, então você pode avançar mais rápido do que a Lei de Moore, porque você pode inovar em toda a pilha.”

A afirmação ousada do CEO da Nvidia vem em um momento em que muitos questionam se o progresso da IA estagnou. Laboratórios de IA líderes - como Google, OpenAI e Anthropic - usam chips de IA da Nvidia para treinar e executar seus modelos de IA, e os avanços nesses chips provavelmente se traduziriam em mais progresso nas capacidades dos modelos de IA.

Esta não é a primeira vez que Huang sugeriu que a Nvidia está superando a Lei de Moore. Em um podcast em novembro, Huang sugeriu que o mundo da IA está em ritmo de “hiper Lei de Moore”.

Huang rejeita a ideia de que o progresso da IA está desacelerando. Em vez disso, ele afirma que agora existem três leis ativas de escalonamento de IA: pré-treinamento, a fase de treinamento inicial em que os modelos de IA aprendem padrões a partir de grandes quantidades de dados; pós-treinamento, que ajusta as respostas de um modelo de IA usando métodos como feedback humano; e computação no tempo de teste, que ocorre durante a fase de inferência e dá a um modelo de IA mais tempo para “pensar” após cada pergunta.

“A Lei de Moore foi tão importante na história da computação porque reduziu os custos de computação”, disse Huang ao TechCrunch. “A mesma coisa vai acontecer com a inferência, onde aumentamos o desempenho e, como resultado, o custo da inferência será menor.”

(Claro, a Nvidia se tornou a empresa mais valiosa do mundo ao surfar o boom da IA, então beneficia Huang dizer isso.)

Os H100s da Nvidia eram o chip de escolha das empresas de tecnologia que procuravam treinar modelos de IA, mas agora que as empresas de tecnologia estão se concentrando mais na inferência, alguns questionaram se os chips caros da Nvidia ainda permanecerão no topo.

Os modelos de IA que usam computação no tempo de teste são caros de executar hoje. Há preocupação de que o modelo o3 da OpenAI, que usa uma versão ampliada de computação no tempo de teste, seja muito caro para a maioria das pessoas usarem. Por exemplo, a OpenAI gastou quase $20 por tarefa usando o3 para alcançar pontuações de nível humano em um teste de inteligência geral. Uma assinatura do ChatGPT Plus custa $20 por um mês inteiro de uso.

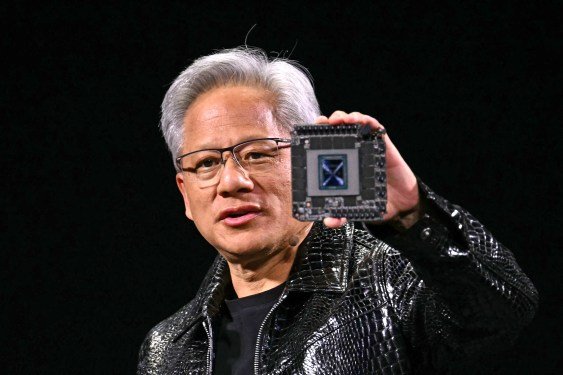

Huang segurou o mais recente superchip de centro de dados da Nvidia, o GB200 NVL72, no palco como um escudo durante a apresentação de segunda-feira. Este chip é 30 a 40 vezes mais rápido para executar cargas de trabalho de inferência de IA do que os melhores chips anteriores da Nvidia, o H100. Huang diz que esse salto de desempenho significa que os modelos de raciocínio de IA como o o3 da OpenAI, que usam uma quantidade significativa de computação durante a fase de inferência, serão mais baratos com o tempo.

Huang diz que está focado em criar chips mais performáticos, e que chips mais performáticos criam preços mais baixos a longo prazo.

“A solução direta e imediata para a computação no tempo de teste, tanto em desempenho quanto em custo acessível, é aumentar nossa capacidade de computação”, disse Huang ao TechCrunch. Ele observou que a longo prazo, modelos de raciocínio de IA podem ser usados para criar melhores dados para o pré-treinamento e pós-treinamento de modelos de IA.

De fato, vimos o preço dos modelos de IA despencarem no último ano, em parte devido a avanços em computação de empresas de hardware como Nvidia. Huang diz que é uma tendência que ele espera que continue com os modelos de raciocínio de IA, mesmo que as primeiras versões que vimos da OpenAI tenham sido bastante caras.

Mais amplamente, Huang afirmou que seus chips de IA hoje são 1.000 vezes melhores do que os que fazia há 10 anos. Isso é um ritmo muito mais rápido do que o padrão estabelecido pela Lei de Moore, um padrão que Huang diz não ver sinais de desaceleração em breve.

O TechCrunch tem uma newsletter focada em IA! Inscreva-se aqui para recebê-la em sua caixa de entrada todas as quartas-feiras.